آموزش کار با Blocked Resources در گوگل وبمستر

گوگل وبمستر که به تازگی با نام Search Console شناخته میشود، ابزاری قدرتمند و کاربردی برای مدیران وبسایت ها می باشد. این ابزار همواره در حال ارتقای امکانات و گزارشات خود می باشد. به تازگی بخش جدیدی به نام Blocked Resources بعنوان زیرمجموعه ای از بخش Google Index اضافه شده است که در این مقاله قصد داریم به معرفی و آموزش آن بپردازیم.

در گذشته روبات های گوگل تنها قادر به درک محتویات متنی و تصاویر موجود در صفحات بودند، به همین دلیل فایل های جانبی مانند CSS و JS را با استفاده از Robots.txt از دسترس آنها خارج میکردیم تا هم زمان آنها برای فایل های نامرتبط هدر نشود و هم منابع سرور بی دلیل استفاده نگردد.

امروزه و با معرفی الگوریتم های جدید مانند Mobilegedon، قدرت تحلیل و درک روبات ها بسیار بهبود یافته و برای شناسایی صحیح محتوای شما به فایل های CSS و JS نیز نیاز خواهند داشت. بعنوان مثال تعیین Mobile Friendly بودن سایت بدون دسترسی به این فایل ها کمی دشوار خواهد بود. در نتیجه گوگل بخش جدیدی را به نام Blocked Resources به معنی “منابع مسدود شده” در پنل وبمستر شما اضافه کرده است تا گزارشی دقیق از آنها داشته باشید.

چه منابعی از سایت توسط robots.txt مسدود شده است؟

روبات های گوگل سایت شما را همانند یک کاربر عادی میبینند، به همین دلیل باید تمام فایل های جانبی مانند تصاویر، CSS و جاوا اسکریپت شما دسترسی داشته باشد. تصور کنید که یک کاربر سایت شما را بدون کدهای CSS ببیند!

اگر فایل robots.txt جلوی دیده شدن این منابع توسط گوگل را بگیرد، می تواند روی ارزش گذاری و تحلیل صفحات توسط گوگل تاثیر بگذارد، که بر رتبه بندی صفحات در نتایج جستجوی گوگل نیز تاثیرگذار خواهد بود.

اطلاعات ارائه شده در Blocked Resources به شما کمک میکند تا منابع مسدود شده برای گوگل و صفحاتی که این منابع در آنها بکار رفته اند را به سرعت پیدا کنید.

در مرحله اول لیستی از دامنه ها به شما نمایش داده میشود. بر روی هریک از این دامنه ها منابعی وجود دارد که دسترسی گوگل به آنها محدود شده است. بعنوان مثال اگر شما یک تصویر را از سایت وان اسکریپت در صفحه خود نمایش داده باشید و وبسیما دسترسی گوگل به آدرس آن تصویر را مسدود کرده باشد، دامنه Onescripr.ir را نیز در این لیست مشاهده خواهید کرد.

البته عموما اطلاعات از روی هاست خودتان دریافت میشوند و ممکن است (همانند تصویر زیر) در این بخش تنها نام سایت خودتان موجود باشد. همانطور که در تصویر مشخص است تنها از یک دامنه مشکل دسترسی به منابع وجود دارد که ۳۵ صفحه از سایت را تحت تاثیر قرار داده است.

با کلیک بر روی هریک از دامنه ها به مرحله بعدی منتقل میشوید.

در مرحله دوم لیستی از منابع مسدود شده بر روی این دامنه به شما نمایش داده میشود که در مقابل هر کدام از آنها مشخص شده چه تعداد از صفحات سایت از این منابع بهره میبرند.

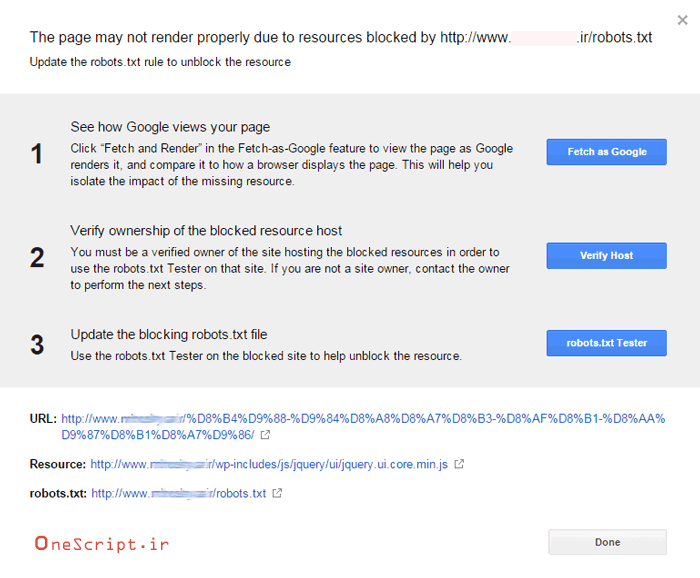

با کلیک بر روی هر یک از این فایل ها لیستی از آدرس صفحات به شما نمایش داده میشود که این فایل در آنها به کار رفته بوده است. همچنین آخرین تاریخ بررسی صفحه توسط گوگل برای شما نمایش داده میشد. با کلیک بر روی هریک از این آدرسها پنجره ای بصورت پاپ آپ برای شما باز میشود.

در این پنجره می توانید دستورالعمل و ابزارهای لازم برای قابل مشاهده شدن آن منابع توسط گوگل را مشاهده کنید.

گزینه یک همان ابزار Fetch as google است. با کلیک بر روی این دکمه صفحه مورد نظر توسط گوگل بازبینی میشود و در دو پنجره مجزا آنچه روبات گوگل مشاهده میکند و آنچه کاربر عادی میبیند را به شما نمایش میدهد (گزینه render حتما فعال باشد) با مقایسه این دو تصویر درک میکنید که دقیقا عدم دسترسی به این فایل چه تاثیری بر تحلیل روبات های گوگل خواهد داشت.

دقت کنید که در حالت های Desktop و Mobile بصورت جداگانه این بررسی را انجام دهید.

گزینه دوم به شما پیشنهاد میدهد که هویت خود را بعنوان مالک آن دامنه یا هاست تایید نمایید. با این کار شما قادر خواهید بود تا با استفاده از robots.txt tester از دسترسی صحیح گوگل به آن فایل مطمئن شوید.

گزینه سوم شما را مستقیما به صفحه robots.txt tester انتقال میدهد. در این صفحه علاوه بر مشاهده محتویات فایل robots.txt این قابلیت وجود دارد که با وارد کردن آدرس یک فایل یا صفحه روی دامنه از دسترسی روبات گوگل به آن مطمئن شد.

در نهایت شما باید با ایجاد تغییرات لازم در فایل Robots.txt دسترسی گوگل به منابع مورد نیاز را فراهم سازید و با استفاده از ابزارهای معرفی شده در بالا از این دسترسی مطمئن شوید.

دیدگاهتان را بنویسید